这里需要用到2个工具:

- Ollama

- Open-WebUI

安装Ollama

Ollama是一个用于本地管理和运行大模型的工具,在官网中下载对应的操作系统版本。

我安装的是mac版本的,mac配置为:M3芯片,内存16G,磁盘空间512G,macOS Sequoia 15.3。

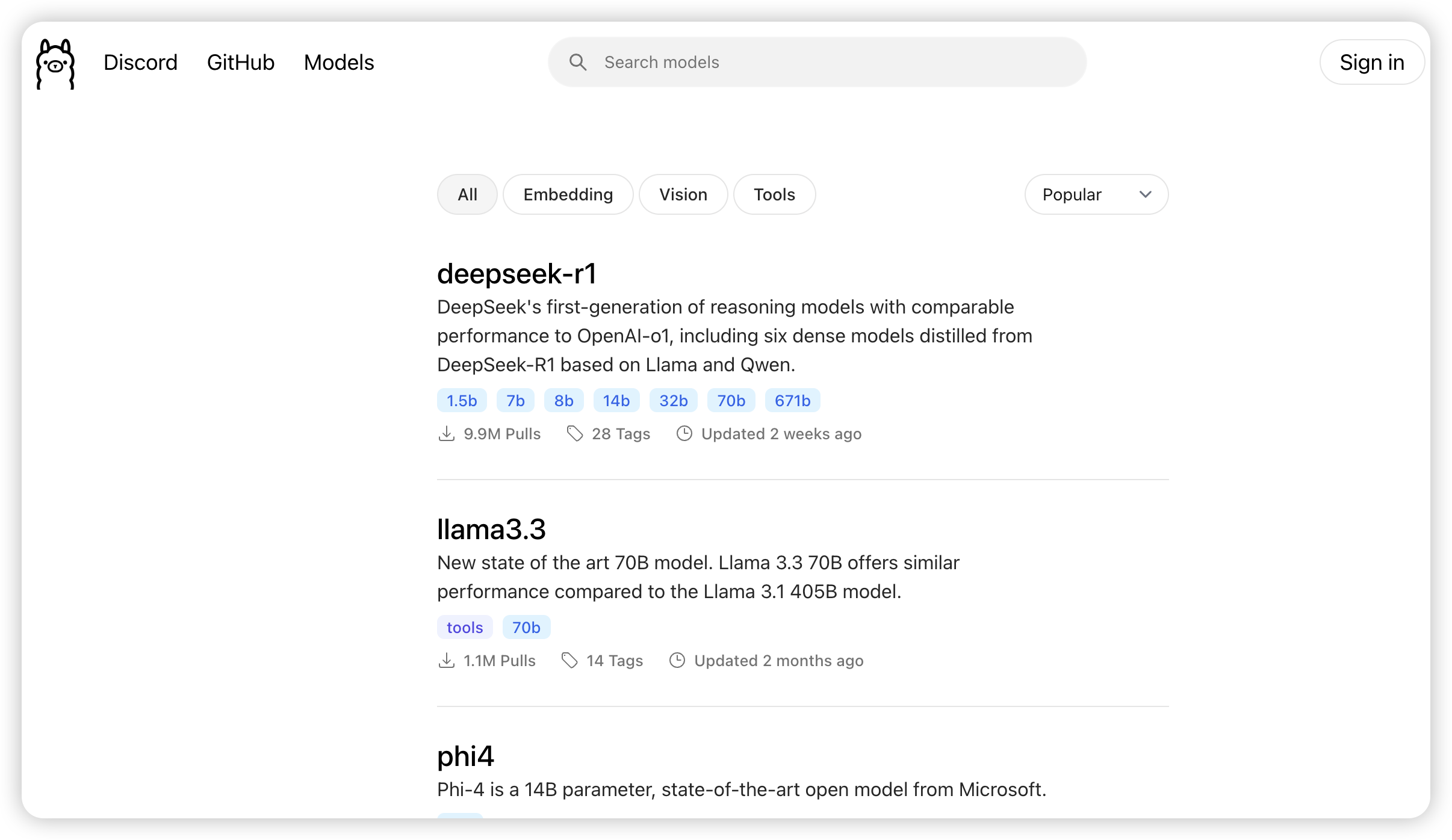

安装成功后返回官网中找到Models,选择要安装的大模型版本

选择deepseek模型版本

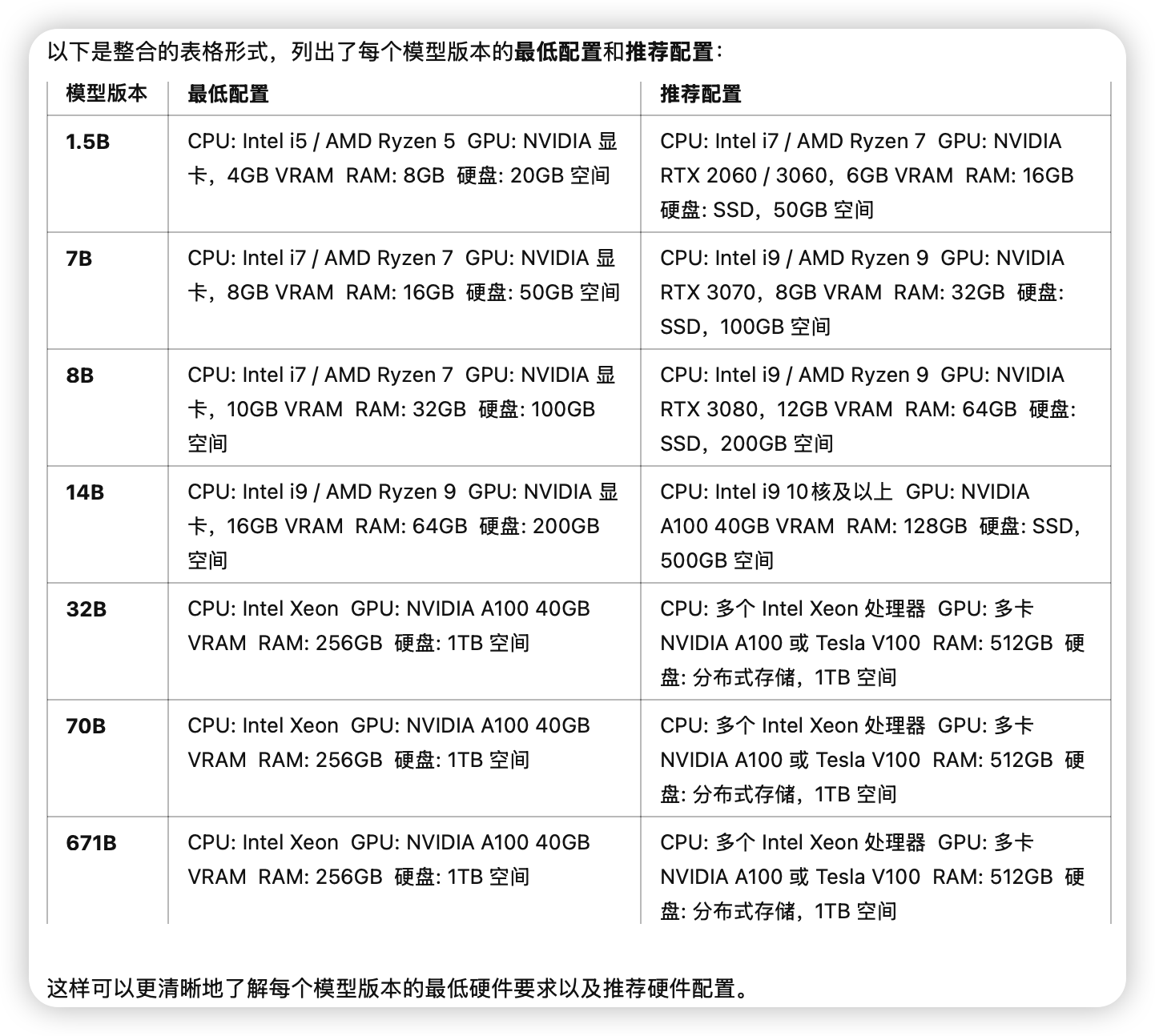

就deepseek模型的版本选择要根据自己的电脑配置来,问问chatGPT,看看它的建议:

这些只是电脑硬件上的差异,还得看看实际的使用场景,简单总结:

- 小型模型(1.5B、7B):适用于轻量级应用、快速原型和小型企业应用,能够满足基本的对话生成、文本处理和问答任务。7B适用于对话系统、推荐系统、内容生成等中等复杂度的场景。

- 中型模型(8B、14B):适用于复杂的对话生成、能够理解上下文、多领域任务、多任务学习,能够提供高质量的自然语言处理服务。例如用于文章生成、内容创作、营销文案等。

- 大型模型(32B、70B):主要用于科研开发、大规模决策分析,能够处理更复杂的推理和跨领域任务。例如高度个性化的产品推荐系统、深度语义搜索引擎、大规模金融分析、医疗数据挖掘、法律文本分析等高度专业化的任务等。

- 超大模型(671B):顶级AI研发和实验应用,适合大规模全球化、多语种的任务,支持最复杂的深度推理和自然语言生成。例如高阶推理、复杂科学模拟、跨领域的AI开发等。

我选择的部署的是deepseek-r1:7b,7B是从qwen2的模型中蒸馏出来的,参数量是7.62B,自注意力有28个头,我的机器应该能跑得起来

部署deepseek

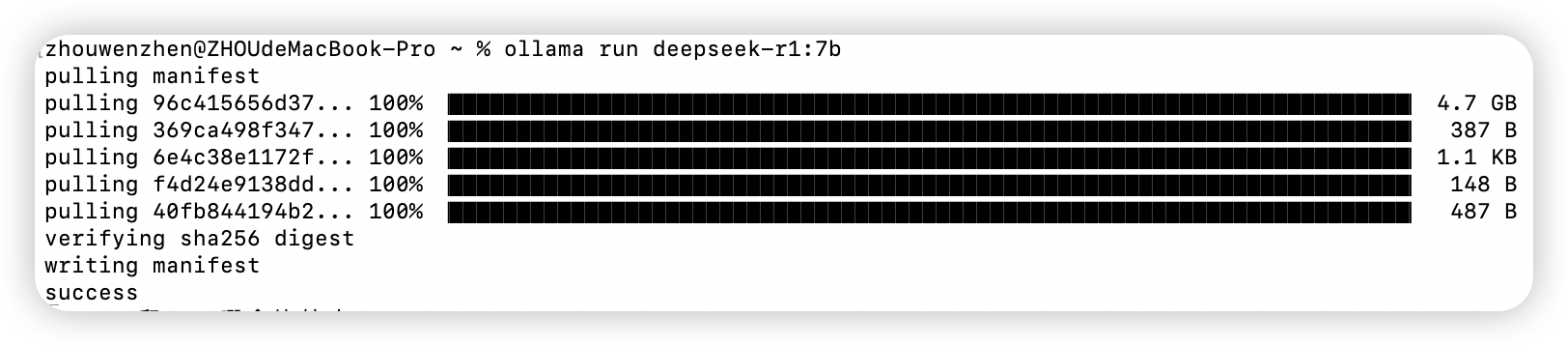

在启动台找到终端(或者是第三方的app也行,我用的是Termius),直接复制以下指令,回车运行。

ollama run deepseek-r1:7b静待模型下载部署(下载的过程着实让人着急),部署成功后即可开始与大模型对话

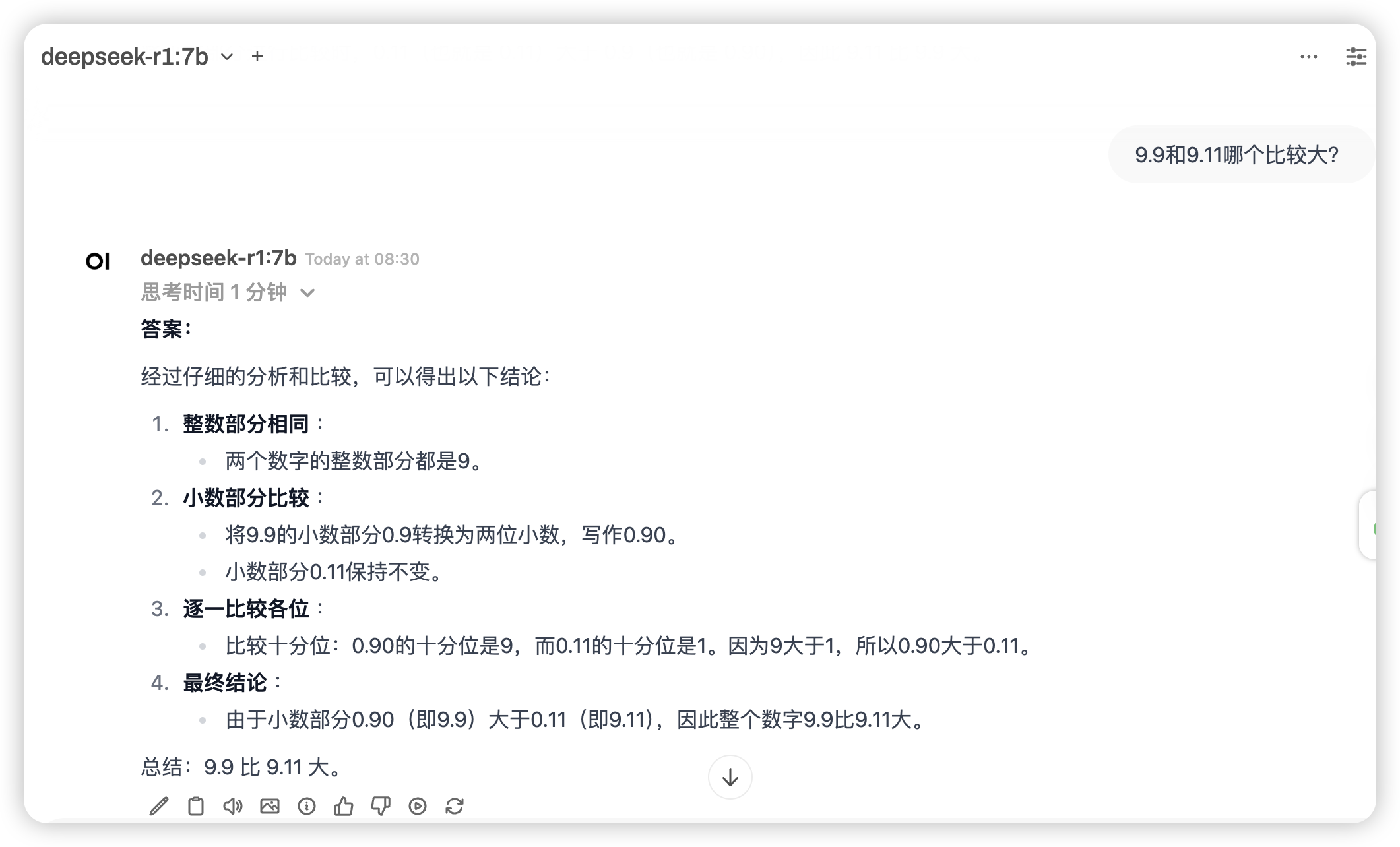

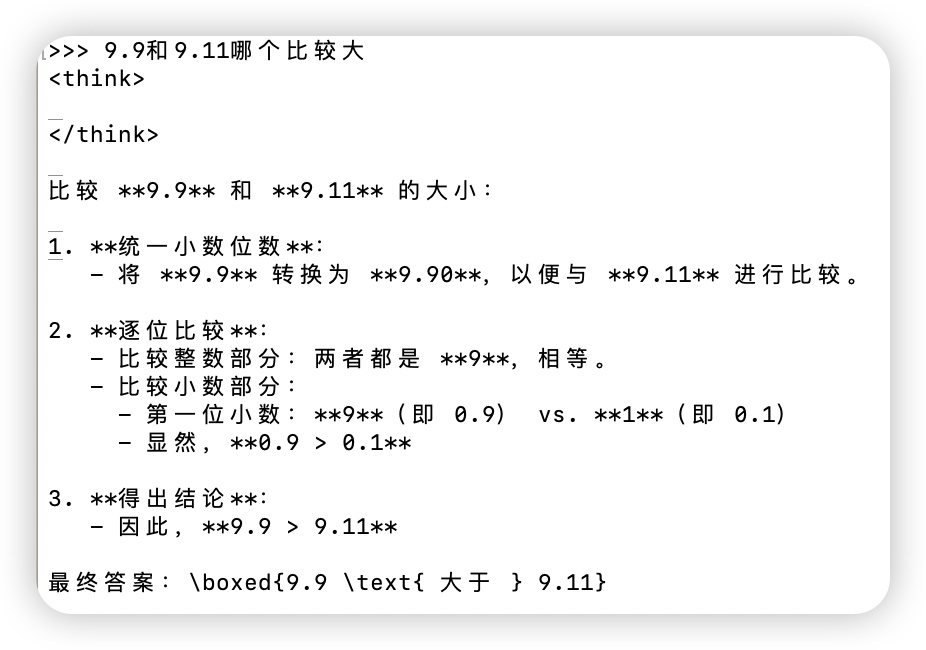

让我们来验证一下模型是否正常运行,问一个经典的比大小例子:9.9和9.11哪个比较大?

套个前端壳子-Open WebUI

不想折腾的可以直接用Chatbox,教程在这

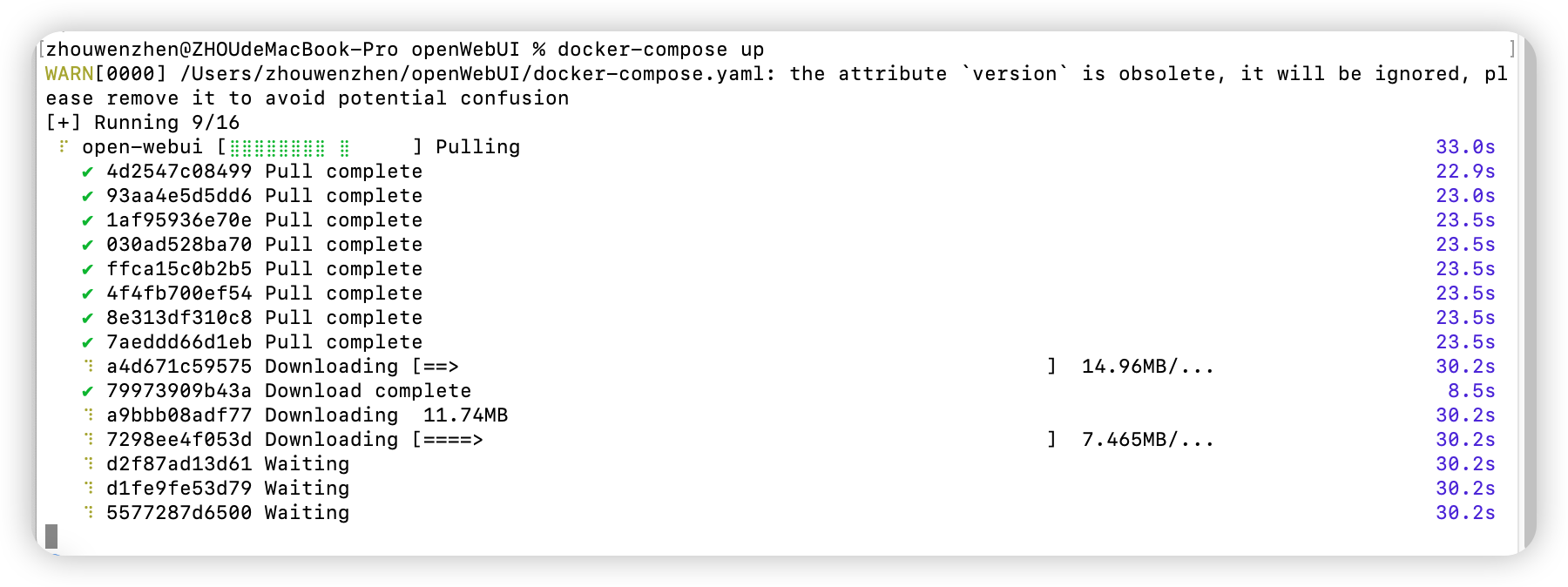

docker部署

我的mac上安装了Docker,就用Docker部署,不需要配置环境

新建一个openWebUI目录,在里面新建docker-compose.yaml

version: '3.8'

services:

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "3000:8080"

extra_hosts:

- "host.docker.internal:host-gateway"

volumes:

- ./data:/app/backend/data

environment:

- ENABLE_OPENAI_API=False

- ENABLE_RAG_WEB_SEARCH=True

- RAG_WEB_SEARCH_ENGINE="duckduckgo"

- RAG_WEB_SEARCH_RESULT_COUNT=3

- RAG_WEB_SEARCH_CONCURRENT_REQUESTS=10

restart: unless-stopped在同级文件夹创建 data 目录,后台启动服务

docker-compose up -ddocker开始拉取镜像部署

部署完成

也可以直接用python安装,在终端或命令行工具中运行以下命令,安装 Open-WebUI:pip install open-webui

OpenWebUI配置

按照提示新建管理员账号

本文著作权归作者 [ tanscp ] 享有,未经作者书面授权,禁止转载,封面图片来源于 [ 互联网 ] ,本文仅供个人学习、研究和欣赏使用。如有异议,请联系博主及时处理。